Commençons donc d'abord par la sensibilisation. Mieux comprendre le numérique et internet à travers son histoire et ses possibles évolutions, mais aussi prendre conscience de ses impacts environnementaux comme sociétaux : c'était l'enjeu d'un grand nombre d'interventions proposés cette journée du 5 avril 2023.

Historique et état des lieux du web⚓

Évolution d’Internet⚓

L’usage d’Internet et du Web nous est désormais familier. Jérôme Kirman, médiateur scientifique de l’unité informatique et sciences du numérique du Palais de la découverte à Universcience est revenu sur la façon dont ces réseaux ont été mis au point et comment ils fonctionnent.

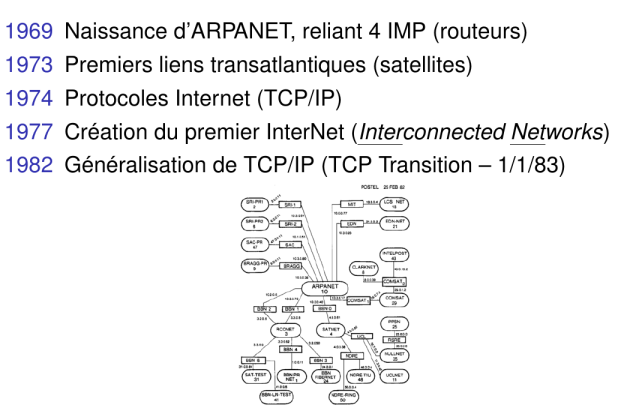

Aux origines

Internet est un réseau qui, via son ancêtre ARPANET, est issu de la rencontre entre un projet militaire et la culture universitaire des années 70. Le modèle qui en a résulté est notoirement décentralisé, d’où son nom : Internet est un réseau formé par l’interconnexion de nombreux réseaux importants (nommés Systèmes Autonomes, ou AS).

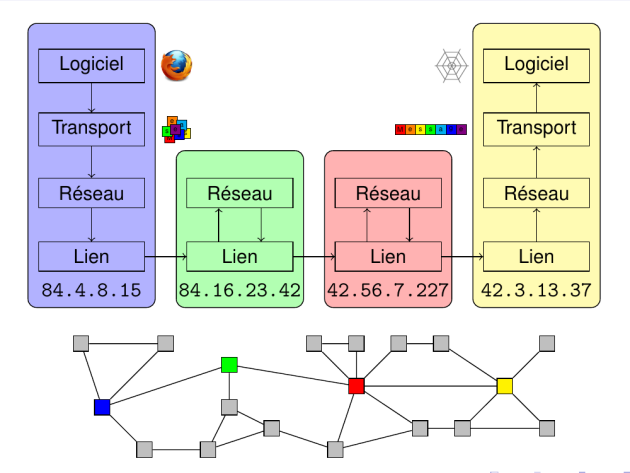

Les principaux acteurs d’Internet (fournisseurs d’accès, de contenus, réseaux universitaires, etc.) relaient mutuellement leur trafic (sous forme de fragments d’information appelés paquets) via différentes routes reliant l’émetteur au destinataire. Ce service mutuel fait l’objet d’accords dits de peering (à titre gracieux pour les acteurs dominants, ou commercial pour les entités de second rang).

Les protocoles qui permettent le fonctionnement du réseau et l’interopérabilité entre tous ses éléments sont publiquement accessibles sous la forme de RFC[*] (Request For Comments), et approuvés à l’unanimité par un groupe de travail international nommé l’IETF (Internet Engineering Task Force). Ce fonctionnement ouvert et transparent, remontant aux débuts de la mise en place d’ARPANET, a permis au réseau Internet de devenir un outil prédominant, unifié et robuste pour la transmission d’information dans le monde entier.

Fonctionnement

Conceptuellement, le fonctionnement d’Internet est relativement simple. Chaque machine visible sur le réseau global possède une adresse IP[*] (Internet Protocol) qui permet de la contacter. Les données sont transmises par petits fragments, appelés paquets. Leur bon acheminement est le plus souvent contrôlé par un système simple d’accusés de réception nommé TCP (Transmission Control Protocol).

Afin d’assurer la robustesse du réseau face aux pannes, les relais par lesquels transitent les messages (appelés routeurs) choisissent à chaque étape, parmi une liste de machines capables d’atteindre le destinataire, celle qui leur semble le plus à même d’acheminer le paquet à bon port. En cas de difficulté de transmission (ou de changement dans l’infrastructure d’interconnexion), ces listes sont mises à jour pour refléter aux mieux les capacités du réseau.

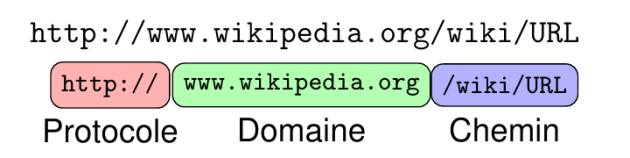

Enfin, par commodité, la plupart des destinations connues (sites webs, messageries, services, etc.) sont désignées par un nom simple plutôt que par leur adresse IP : ce sont les noms de domaine (terminés par .com, .org, .fr, etc.). Un système d’annuaires nommé DNS (pour Domain Name System) permet à n’importe quel ordinateur sur le réseau de mettre en correspondance ces noms avec les adresses IP actuelles des machines associées.

Démocratisation

Au début des années 90, la multiplication des ordinateurs personnels dans les foyers a conduit à l’apparition des FAI (Fournisseurs d’Accès à Internet), qui offrent aux particuliers un accès individuel au réseau Internet. Cette démocratisation coïncide avec l’apparition du World Wide Web (à l’initiative de Tim Berners-Lee, alors ingénieur de recherche au CERN). Ce dernier consiste originellement en une collection de documents reliés par des hyperliens, mis en ligne et accessibles de manière transparente à travers le réseau Internet.

La démocratisation d’Internet est allée de pair avec l’adoption massive du web, qui en devient alors l’usage dominant. Ce dernier a rapidement évolué de deux façons :

d’une part, les ressources mises à disposition sur le web ont cessé d’être exclusivement des documents hypertextes consultables publiquement pour inclure également des applications et services dynamiques avec lesquels les utilisateurs et utilisatrices peuvent éventuellement interagir (souvent désigné sous le terme de « Web 2.0 »),

d’autre part, une grande partie des sites Web majeurs sont aujourd’hui des services commerciaux ; le modèle économique dominant est celui de la gratuité publicitaire : les contenus et services sont accessibles gratuitement aux utilisateurs et utilisatrices. Les revenus du site proviennent des régies publicitaires qui atteignent ainsi un large public (ce modèle aujourd’hui dominant n’est toutefois pas universel : Wikipédia est un contre-exemple notoire).

Centraliser ou fédérer : le dilemme des réseaux⚓

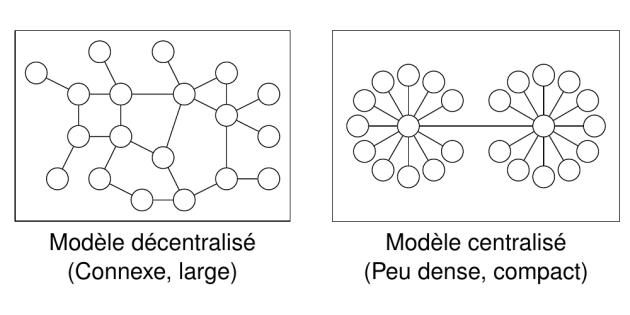

Jérôme Kirman est ensuite revenu sur la nature décentralisée d'internet mais aussi sur la concentration du web moderne autour d’un petit nombre de plateformes aux pouvoirs considérables. Pourquoi ce modèle, et quelles en sont les alternatives ?

Réseaux sociaux et effets de réseau

Avec la démocratisation de l’informatique et de l’accès à Internet, les usages sociaux du réseau se sont énormément développés : d’un usage de niche centré autour de petites communautés dans les années 80 et 90, les interactions entre personnes sur Internet sont devenues monnaie courante, parfois en se substituant mais souvent en s’ajoutant aux modes de communication préexistants.

Cet accroissement des communications numériques a favorisé la mise en place de plate-formes centralisées avec une expérience unifiée, en raison des effets de réseau inhérents à ces usages : en effet, une plate-forme d’échanges qui regroupe un plus grand nombre d’utilisateurs et utilisatrices est un lieu privilégié pour permettre à un nouvel usager de retrouver ses connaissances, ou pour en former de nouvelles. En l’absence d’interopérabilité, une plate-forme réunissant beaucoup d’utilisateurs et utilisatrices va donc tendre à en attirer toujours plus, aux dépends des autres plate-formes existantes (notamment parce que l’expertise et le temps d’attention des utilisateurs et utilisatrices sont limités, conduisant à une concurrence entre les usages).

En raison de cette tendance, un petit nombre de plate-formes ont émergé comme des acteurs dominants et difficilement contournables des activités sociales : Facebook, YouTube, Instagram, Twitter concentrent des centaines de millions voire des milliards d’utilisateurs et utilisatrices. Certaines tendances démographiques et culturelles permettent à ces plates-formes de coexister, mais la concurrence entre elles demeure faible.

Modèle économique

Ces réseaux sociaux appartiennent tous à des entreprises privées, qui cherchent à dégager un profit. L’accès à ces plate-formes n’étant pas payant pour les utilisateurs et utilisatrices (car il freinerait l’adoption et handicaperait lourdement la plate-forme face à un concurrent potentiel), leur modèle économique s’appuie généralement sur la publicité : des régies publicitaires rémunèrent ces acteurs dominant en échange d’un accès privilégié à l’attention de leurs usagers. Ce modèle économique entraîne un désalignement entre les intérêts des différents acteurs : les publicitaires sont les véritables clients de l’entreprise, alors que les personnes qui utilisent la plate-forme pour communiquer en sont le produit d’appel.

De ce fait, ces plate-formes sont victimes de nombreux effets pervers et incitations problématiques ; parmi lesquelles (sans exhaustivité) :

Les effets de réseau mentionnés précédemment entraînent une cimentation des acteurs du paysage : un nouveau réseau social, même appuyé par des financements et un marketing considérable dès sa création, n’a que peu de chances d’attirer assez d’usagers pour devenir un concurrent sérieux. Cette absence de concurrence libre empêche l’innovation et l’évolution des services existants.

La taille des réseaux résultants rend difficile voire impossible le passage à l’échelle de différents services afférents, dont l’existence est normalement tenue pour acquise : la lutte contre le harcèlement ou le support technique sont réduits à leur plus simple expression (au minimum légal, s’il existe, voire moins), dans la mesure où l’entreprise propriétaire n’a pas les moyens de répondre aux demandes d’un ensemble d’usagers aussi large que le sien.

La communauté des usagers étant trop large pour constituer un groupe socio-culturel unifié, la politique de modération (ou de censure) en vigueur sur le réseau est forcément inadéquate pour beaucoup d’usagers, dans la mesure où elle est généralement unique à l’échelle du réseau (l’alternative consistant à appliquer des règles différentes, ou de manière sélective, à différents groupes d’individus n’étant guère préférable, et peu soutenable de toute façon à l’échelle d’un si vaste réseau).

La nécessité de faire face aux larges coûts de fonctionnement, et la recherche du profit par les entreprises détentrices de ces réseaux pose des difficultés supplémentaires. D’une part, tarifer directement certains usages pour les utilisateurs et utilisatrices reviendrait à déclasser socialement les plus précaires (et nuit par ailleurs aux effets de réseau nécessaires à la perpétuation de la plate-forme). D’autre part, le modèle publicitaire qui sert d’alternative incite une large part de la population à la surconsommation, à une période où les conséquences écologiques de celle-ci deviennent de plus en plus préoccupantes.

L’intérêt des régies publicitaires passe par la captation de l’attention et l’augmentation du temps d’activité des usagers. Cette maximisation de l’engagement est le plus souvent délibérée, mais est qu’il en soit inéluctable pour une plate-forme qui souhaite conserver sa position dominante. Les outils et expériences de manipulation psychologique (A/B testing, lecture automatique, FOMO, etc.) employés à cet effet posent nombre de problèmes éthiques. En outre, les algorithmes de mise en relation et de recommandation, mêmes automatiques et s’appuyant sur des données objectives, favorisent non seulement des problèmes d’addiction mais aussi la haine en ligne, car les altercations entre individus sont naturellement génératrices d’engagement.

Enfin, la concentration des données personnelles d’un grand nombre d’individus en un même endroit fait des bases de données de ces réseau une cible tentante, non seulement pour des transactions monnayant ces données sans le consentement des utilisateurs et utilisatrices concerné·e·s (limité en Europe par le RGPD, mais pas impossible pour autant), mais aussi pour des agences gouvernementales agissant hors de tout cadre légal, et pour des organisations criminelles pouvant tirer avantage (notamment par usurpation d’identité).

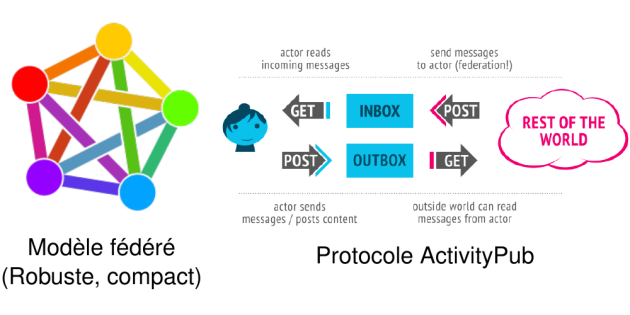

Modèle fédéré

Face à ces inconvénients, nombre d’usagers sont à la recherche d’un modèle alternatif pour les réseaux sociaux. Une réponse possible est la balkanisation des réseaux sociaux : en éclatant les grandes plate-formes pour obtenir un écosystème plus fragmenté, beaucoup espèrent recréer des communautés à taille humaine, ressemblant davantage aux forums et blogs qui ont dominé la première décennie du Web. Cela permettrait une modération adaptée, une liberté de circulation entre les communautés, et réduirait les effets pervers dus aux contraintes économiques.

Cependant, un avantage majeur des réseaux sociaux centralisés est la facilité de se mettre en rapport avec n’importe quel usager, sans devoir rechercher, rejoindre et s’accoutumer à l’usage d’une nouvelle plate-forme. La composante manquante des forums et sites personnels est l’interopérabilité, la possibilité d’échanger des informations sans passer par des méthodes dédiées au cas par cas. Traditionnellement, sur Internet, la conception d’interfaces universelles passe par la mise au point d’un protocole : à date (2023), le principal protocole développé en réponse au besoin de fragmenter les réseaux sociaux se nomme ActivityPub.

Le protocole ActivityPub spécifie comment des instances (applications ou sites web compatibles) peuvent échanger des objets (les contenus), proposés par leurs acteurs (les usagers), en fonction de leurs relation de suivi. Par exemple, si Alice propose sur sa plateforme Wonderland des contenus qui intéressent Bob, utilisateur et utilisatrice de SpongeWorld, ce dernier peut choisir de la suivre : SpongeWorld communique alors cette demande à Wonderland, qui transmettra en réponse les futurs contenus d’Alice vers SpongeWorld, afin qu’ils soient délivrés à Bob. Le protocole ActivityPub comprend également des dispositions pour rendre interopérables les interactions les plus courantes des réseaux sociaux actuels : approbation, rediffusion, collection… Par vocation, ce protocole vise à être implémenté sur toutes les futures plate-formes sociales (éventuellement en complément d’autres protocoles concurrents), créant ainsi une vaste fédération de petits réseaux sociaux qui échangent des contenus de gré à gré.

Usages et évolution

Un certain nombre d’applications supportent actuellement des protocoles de fédération, pour des usages très variés. Ce sont généralement des logiciels libres, ce qui permet à n’importe qui de créer sa propre instance pour son usage ou celui d’autrui. Le protocole assure ensuite la compatibilité entre ces instances, ce qui permet à tous leurs usagers d’échanger sans s’inquiéter de ces questions. Parmi les applications majeures (sans exhaustivité) supportant cette fédération, on trouve :

Mastodon (microblogging, comparable à Twitter)

PeerTube (hébergement vidéo indépendant, alternatif à YouTube)

Mobilizon (agenda public, similaire aux évènements Facebook)

Nextcloud (hébergement et partage de fichiers, similaire à Dropbox)

Funkwhale (hébergement audio, inspiré par Grooveshark)

Pixelfed (partage d’images, similaire à Instagram)

Pour finir, le modèle fédéré est un système alternatif aux géants du web en pleine expansion, mais encore peu répandu depuis son introduction en 2018. L’ensemble des instances compatibles avec des protocoles de fédération est appelé Fédivers. Les plate-formes traditionnelles (Facebook, Twitter, etc.) n’ont naturellement pas adopté de protocoles comme ActivityPub, leur usage est souvent favorisé par les milieux militants : libristes et partisans des communs (culture ouverte), défenseurs des minorités (ActivityPub est pensé notamment pour permettre de limiter le harcèlement en ligne), ou encore militants pour la liberté d’expression (parfois mis à l’écart des plate-formes dominantes). Bien que plusieurs de ces communautés aient des objectifs et des valeurs contraires, la nature décentralisée du Fédivers leur permet d’y coexister.

La Liberté guidant le code – Une histoire du logiciel libre⚓

Au travers d’un historique du logiciel libre et de l’open source, Jérôme Kirman a détaillé les notions de logiciel (libre ou non), de licences, de droit d’auteur.

Matériel et logiciel

Durant les premiers temps de l’informatique, les ordinateurs étaient des appareils coûteux et dont la disponibilité était limitée. Le matériel concentrait alors toute la valeur économique et la majorité de l’attention, tandis que le logiciel avait, en comparaison, une valeur très réduite. Exacerbant cet état de fait, les logiciels étaient souvent développés pour être exécutés sur un modèle ordinateur en particulier, limitant grandement leur portée.

Au cours des années 70 cependant, l’émergence des mini-ordinateurs de série et des premiers micro-ordinateurs (ainsi que le développement de langages de programmation de haut niveau) entraîne à la fois une diminution relative de la valeur du matériel, et une augmentation considérable de la valeur du logiciel, qui peut désormais être développé une fois pour être ensuite déployé sur de nombreuses machines compatibles.

Cette augmentation durable de la valeur du logiciel entraîne des conséquences économiques : auparavant dénué de protection juridique, la copie et la modification de logiciels vont être limités à partir de cette époque pour permettre aux acteurs émergents du logiciel de gagner en profitabilité.

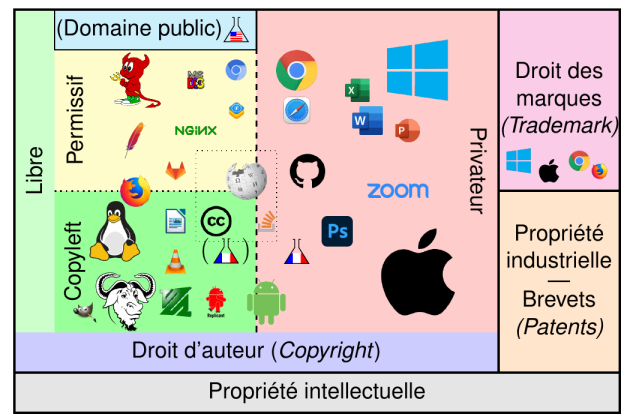

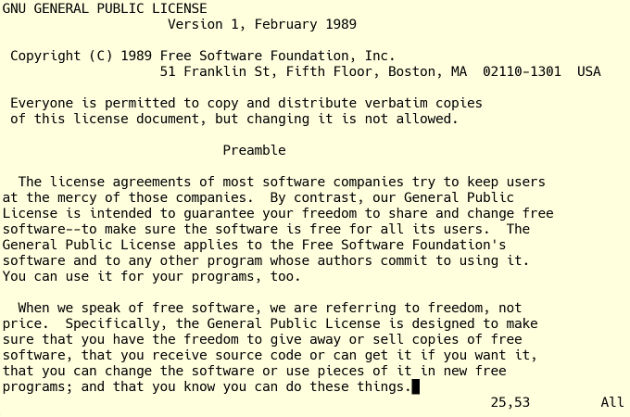

Droit d’auteur et logiciel libre

Le régime juridique utilisé pour la protection du logiciel est le copyright américain, qui correspond en France au droit d’auteur. Rapidement résumé, celui-ci recouvre toute œuvre de l’esprit en interdisant la reproduction et la diffusion de cette œuvre sans le consentement de l’ayant droit (consentement qui peut être accordé par contrat, éventuellement contre rémunération). Ce dernier est par défaut l’auteur de l’œuvre, mais ce droit dit patrimonial est cessible (et en particulier, dans le cas du logiciel, la cession des droits d’auteurs au bénéfice de son employeur est présumée). Cette protection, en Europe, dure jusqu’au décès de l’auteur et pendant 70 ans de plus, ce qui entraîne mécaniquement que l’ensemble des logiciels existants sont encore soumis au droit d’auteur pour une durée significative.

Cependant, lors de la mise en place de ce régime juridique, nombre d’auteurs de logiciels étaient issus du monde académique, et en particulier de la culture hacker des campus universitaires américains. Parmi ces derniers, beaucoup voyaient d’un œil hostile la mise en place de restrictions juridiques qui empêchaient la libre diffusion du savoir et des outils de l’informatique qu’ils tenaient pour un bien commun de l’humanité. C’est de cette opposition qu’est né le concept de logiciel libre.

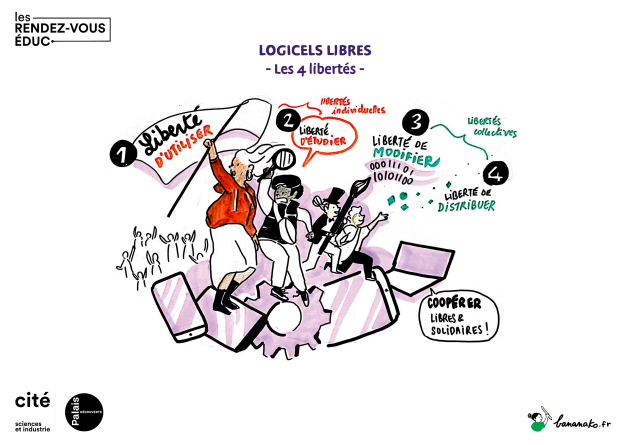

Un logiciel libre est, comme tout logiciel, soumis au droit d’auteur ; cependant, il présente la particularité que ses ayants droits accordent aux utilisateurs et utilisatrices (usuellement par l’intermédiaire d’un contrat appelé licence) un ensemble large, durable et transférable d’autorisations qui annulent en pratique les restrictions dues au droit d’auteur. La définition généralement acceptée du terme « logiciel libre » est celle de la FSF (Free Software Foundation), qui repose sur quatre libertés fondamentales (numérotées de 0 à 4) dont doit disposer l’utilisateur et l'utilisatrice :

0. Liberté d’utiliser le logiciel, sans restriction.

2. Liberté d’étudier et modifier le logiciel (par le biais de son code source).

3. Liberté de recopier et partager le logiciel avec toute autre personne.

4. Liberté de diffuser des versions modifiées, au bénéfice de la communauté.

Open Source et aspects pratiques

Le mouvement du logiciel libre a connu un certain succès tout au long de son histoire, notamment par l’entremise du projet GNU (visant à concevoir un système d’exploitation complet et libre) et son noyau Linux (développé au début des années 90 pour adapter GNU aux nouveaux modèles d’ordinateurs personnels). Cependant, les systèmes GNU/Linux sont historiquement peu connus du grand public, notamment en raison de l’hégémonie des systèmes Microsoft dans le monde des ordinateurs personnels. Face à cette emprise, certains partisans des logiciels libres ont choisi de concentrer leurs efforts sur la compétitivité de ces derniers, au travers du mouvement de l’open source.

Bien que leurs définitions soient légèrement différente, les termes « open source » et « logiciel libre » désignent en pratique les mêmes logiciels. La principale différence est d’ordre philosophique : là où les défenseurs du logiciel libre mettent l’accent sur les libertés accordées aux usagers par ces logiciels, le monde de l’open source met l’accent sur la supériorité technique et la compétitivité des logiciels développés de manière transparente et collaborative.

Aujourd’hui, l’emploi du logiciel libre est généralisé : une grande partie de l’infrastructure d’Internet repose sur des systèmes libres, le système d’exploitation le plus largement déployé, Android, utilise un noyau Linux, et les principaux navigateurs Internet sont développés de manière collaborative (Chrome, Firefox, Edge, etc.). Cependant, le bénéfice des libertés logicielles associées reste limité, ou invisible pour la plupart des utilisateurs et utilisatrices. En particulier, nombre de géants du numérique (Google, Microsoft, Apple, Facebook, Amazon) ont adopté deux pratiques qui en limitent la portée :

Le développement dit open core, consistant à faire développer un logiciel open source avec l’aide de la communauté, avant d’en distribuer une version non-libre incluant un petit nombre de modifications confidentielles autour du programme de base (c’est par exemple le cas de Chrome ou Edge, dont l’essentiel du fonctionnement vient d’un navigateur open source baptisé Chromium, mais peu connu des usagers).

L’industrie des services logiciels, consistant à adopter et modifier des logiciels libres avant de les mettre à disposition par l’intermédiaire d’un service accessible via Internet : le logiciel lui-même est alors utilisé à distance dans un navigateur web par les usagers, et les libertés accordées par sa licence ne s’appliquent pas (car le logiciel n’est pas distribué). Certaines licences libres interdisent ces pratiques, mais elles demeurent aujourd’hui minoritaires.

Le logiciel libre : quand l’informatique est vecteur d’émancipation et de coopération⚓

Les ordinateurs occupent un rôle central dans nos vies. Ils manipulent nos informations grâce aux programmes informatiques, les « logiciels ». Il est donc légitime de se demander qui écrit ces logiciels, qui les contrôle et à quelles fins. Si certains logiciels fonctionnent délibérément de façon opaque, nous mettant de fait à la merci de leurs éditeurs, il existe une vision solidaire de l’informatique basée sur le partage de la connaissance et en faveur de l’émancipation des utilisateurs et utilisatrices.

Cette vision anime le mouvement du « logiciel libre » présenté par Isabella Vanni, coordinatrice vie associative et responsable projets au sein de l’association April, notamment en charge des actions de sensibilisation au logiciel libre.

L'April est la principale association de promotion et de défense du logiciel libre dans l'espace francophone. Créée en 1996, elle regroupe près de 3 000 membres (personnes physiques, entreprises, associations, collectivités, organismes du secteur éducatif). L'association œuvre pour sensibiliser l'opinion sur les dangers d'une appropriation exclusive de l'information et du savoir par des intérêts privés. Elle mène également des actions de plaidoyer politique pour obtenir des décisions favorables au développement du logiciel libre et pour défendre les libertés informatiques quand nécessaire. https://www.april.org

Objectifs de cette présentation :

Présenter le logiciel libre et ses enjeux

Présenter l'April

Donner des moyens pour s'informer et agir

Qu’est ce que c’est qu’un logiciel libre ? Commençons par rappeler ce que c’est un logiciel.

Un logiciel, c’est un programme informatique qui donne des instructions à un ordinateur, afin que ce dernier effectue certaines opérations.

Aujourd’hui, l’informatique joue un rôle très important dans la vie quotidienne de beaucoup de personnes. Je ne sais pas combien de personnes dans cette salle aujourd’hui pourraient se passer facilement d’un ordinateur, rien que pour une journée ?

Attention, j’inclus bien sûr les « smartphones » car il s'agit d'ordinateurs à part entière.

Et il n'y a pas que nos ordinateurs, il y aussi ceux qui nous permettent d'accéder aux pages web et qui nous fournissent des services en ligne (courriel, visioconférence, etc.).

Il est donc légitime, et même recommandé, de se demander qui donne les instructions à nos ordinateurs, c'est à dire qui écrit ces logiciels - qui les contrôle et à quelles fins.

Pourquoi l’adjectif « libre » ?

Quand on parle de logiciel libre, on parle d’un logiciel publié sous une licence qui garantit certaines libertés aux personnes qui utilisent le programme. Grâce à ces libertés, les utilisateurs et utilisatrices contrôlent le programme.

On parle de logiciel « non libre » ou encore mieux « privateur » quand ces mêmes libertés sont niées aux utilisateurs et utilisatrices.

Dans le cas d’un logiciel privateur, ce ne sont plus les personnes qui contrôlent le programme, mais l’inverse : c’est le programme (et donc son éditeur) qui contrôle les usages, et donc les utilisateurs et utilisatrices.

C’est important d’avoir conscience que c’est toujours l’une ou l’autre situation, il n’y a pas de situations intermédiaires.

Je vous invite donc à vous demander si vous préférez contrôler le programme ou bien subir le contrôle de l’éditeur. Voyons en détail ces libertés garanties par le logiciel libre.

Liberté d’utilisation

C’est la liberté d’exécuter le programme, sans restrictions et pour n’importe quel usage.

Grâce à cette liberté, par exemple, je suis libre d’exécuter le programme sur un nombre illimité de machines.

Avec un logiciel privateur, c’est l’éditeur qui décide pour moi. Par exemple, il peut m’empêcher d’exécuter un programme sur un ordinateur, car la licence limite à 10 le nombre de machines sur lesquelles je peux installer le logiciel et que j’essaie de l’exécuter sur la 11e machine. Pour n'importe quel usage, car ce n'est à pas à l'éditeur de décider quel usage je peux faire du programme.

Liberté d'étudier

C’est la liberté d’étudier le fonctionnement du programme.

Vous avez le droit de savoir comment est fabriqué le logiciel et ce qu'il fait réellement.

La condition nécessaire de cette liberté est l’accès au « code source », la « recette » de fabrication du logiciel, en quelque sorte.

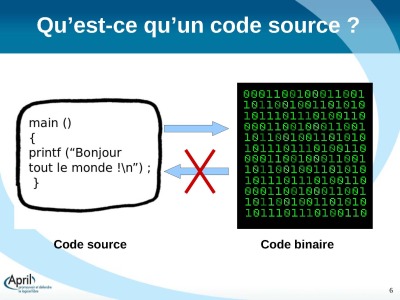

Mais qu’est-ce que le code source ?

Il y a deux versions du même logiciel. Il y d’abord la version écrite par des personnes compétentes en développement dans un langage de programmation : c’est ce qu’on appelle le « code source ».

Toute personne qui connaît la programmation peut lire et comprendre cette version du logiciel et la modifier.

L’ordinateur, lui, ne comprend que le langage binaire (les 0 et les 1). Il faut donc faire une traduction (c’est un logiciel dit compilateur qui s’occupe de ça) pour que l’ordinateur puisse lire et exécuter les instructions contenues dans le programme. Or, il est très difficile, voire impossible, pour un humain de comprendre le langage binaire. Et la rétro- ingénierie prendrait des temps bibliques.

D'où la nécessité d’avoir accès au code source pour comprendre les instructions que le logiciel donne à notre machine.

Lorsque l'on ne dispose pas du code source, on ne peut pas vérifier la véracité de ce que le logiciel fait. L'éditeur maintien un contrôle total sur le programme. Ceci constitue déjà une injustice en soi, car ça nous met à sa merci.

De plus, l'expérience montre que l’éditeur profite souvent de ce pouvoir pour insérer des fonctionnalités malveillantes dans les logiciels, comme les espions logiciels (spyware), les portes dérobées (backdoors) et les dispositifs de contrôle d’usage (DRM - Digital Rights Management).

Si on ne connaît pas la programmation, on n’est pas bien sûr en mesure de lire le code source, on ne sait pas quelles sont les instructions que l’ordinateur reçoit. Mais l'accès au code source, c’est la garantie qu’un·e informaticien·ne compétent pourra toujours voir à l’intérieur s’il n’y a pas des choses bizarres, risquées… Ainsi, les programmes libres ont une réputation de fiabilité et de sécurité : on a le droit de savoir ce qu’on mange.

Liberté de modifier

C'est la liberté de modifier le programme pour l'améliorer, l'adapter à ses besoins (par exemple, en ajoutant une fonctionnalité), corriger des anomalies, ajouter une traduction, etc..

C'est aussi la liberté de demander à d'autres personnes compétentes (bénévoles ou professionnelles) de faire ces modifications pour vous, si vous ne connaissez pas la programmation.

Liberté de distribuer des copies du logiciel

Vous avez le droit de faire autant de copies que vous voulez de ce logiciel et de les distribuer à autant de personnes que vous le voulez.

Grâce a cette liberté, on peut aider son prochain et on garde un contrôle collectif sur le programme.

Toute personne compétente peut vérifier la qualité du code. En particulier, il sera toujours possible, légalement et techniquement, de vérifier que le logiciel ne fait pas autre chose que ce qu’il a annoncé (par exemple, qu’il ne fouille pas dans notre disque dur, qu’il ne collecte et transfère pas de données à notre insu, bref qu’il n’est pas un logiciel espion ou spyware).

Grâce à ces quatre libertés, les personnes sont libres de travailler ensemble pour apporter des changements et des améliorations au programme et pour en faire profiter d’autres.

Ainsi, le logiciel libre est une formidable occasion de partage, d’échange et de coopération entre les membres d’une communauté d’utilisateurs et utilisatrices.

Grâce au logiciel libre, comme on a vu, on garde le contrôle du programme. Ainsi, le logiciel libre incarne informatiquement la devise républicaine « Liberté, égalité, fraternité » :

liberté, car on peut faire ce que l’on veut avec le programme : ce n’est pas l’éditeur qui décide combien de bribes de liberté nous accorder après avoir décidé à notre place, ce n'est pas à lui de décider pour nous de ce qu'il convient de faire ou de ne pas faire ;

égalité, car chacun et chacune a les mêmes libertés face au logiciel. Il n'y a pas de configuration où un acteur serait tout puissant, en situation d'imposer ses choix aux autres.

fraternité, car le logiciel libre encourage, comme nous avons vu, le partage du savoir, l’échange, la collaboration.

Interopérabilité

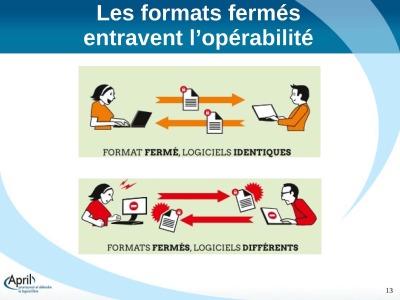

La compatibilité est la possibilité pour deux systèmes de types différents de communiquer ensemble.

Lorsqu'un acteur devient dominant dans un domaine, les autres acteurs font en sorte d'être compatibles avec lui.

Avantage : l'ensemble des systèmes peuvent à peu près communiquer ensemble.

Inconvénient : l'acteur dominant contrôle d'une certaine manière cette possibilité.

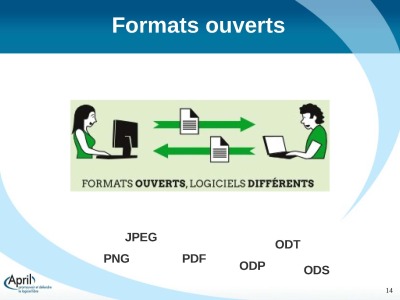

L'interopérabilité est la possibilité pour différents systèmes de communiquer entre eux sans dépendre d'un acteur particulier. Elle repose sur la présence d'un standard ouvert, un format dont les spécifications techniques sont publiques.

Les spécifications des formats fermés peuvent être accessibles, mais leur mise en œuvre reste restreinte juridiquement ou techniquement.

L'informatique propriétaire révèle sa dimension privatrice quand elle utilise volontairement des formats de fichiers incompatibles avec les autres solutions.

Pour que vos documents puissent être lus facilement par d’autres personnes, sans avoir besoin de vous soucier du logiciel qu’elles utilisent, choisissez des formats ouverts.

Exiger l’interopérabilité, c'est se libérer pour communiquer librement.

Exactement comme le code source d'un logiciel libre qui est ouvert, la structure d'un format de fichier ou protocole de communication gagne à être diffusée.

Cela permet à quiconque d'intégrer ces fichiers ou ces moyens de communication à ses propres solutions informatiques et les adapter à ses besoins.

Pérennité

Les documents enregistrés en un format ouvert pourront toujours être relus, car ils ne sont pas dépendants d'un logiciel en particulier.

On conserve le contrôle des documents qu'on produit, sans le risque d’obsolescence au moment du passage d’une version à une autre.

Logiciels libres à l'école

Quelles est la mission de l'école ?

transmettre connaissances et compétences, certes

mais aussi éduquer à la citoyenneté, former les élèves à être des citoyens et citoyennes qui agissent dans et pour une société libre et solidaire

Les logiciels privateurs sont verrouillés, ils restent sous le contrôle exclusif de leur éditeur, considèrent le savoir comme un secret, et sont donc intrinsèquement des ennemis de l'éducation. Les logiciels libres considères le savoir comme une richesse à partager.

Les logiciels privateurs ont une approche de l'informatique exclusivement centrée sur la transmission de recettes toutes faites plutôt que sur l'acquisition de l'autonomie.

Les logiciels et les ressource pédagogiques sous licences libres laissent libre place au partage, à l'amélioration, à la modification.

Les termes « logiciel libre » et « open source » font référence à peu près à la même gamme de logiciels.

Mais ces termes n'expriment pas les mêmes valeurs !

Le mouvement du logiciel libre milite pour les libertés des utilisateurs et utilisatrices de l'informatique.

L'idéologie open source met l'accent sur les avantages pratiques pour le développement logiciel et sur la qualité des produits. En d'autres termes, elle ne se pose pas de questions sur ce qui est juste ou pas : elle a une position neutre face aux enjeux de liberté et justice.

Notons au passage qu'il y a des logiciels non libres dont le code est consultable (donc « ouvert ») sous condition.

Complément : Support de présentation

Complément : Ressources

Pour prolonger et accéder à plus de ressources, voir la partie « Envie d'aller plus loin ? » page 18 du support de présentation téléchargeable ci-dessus.

Impacts environnementaux du numérique⚓

Du constat à la démarche numérique responsable⚓

L'impact environnemental du numérique a été présenté par Vincent Courboulay, enseignant-chercheur à La Rochelle Université, cofondateur et scientifique de l’Institut du Numérique Responsable (INR).

L’INR est une association de loi 1901 qui a pour objet d’être un lieu de réflexion sur les trois enjeux clés du numérique responsable :

la réduction de l’empreinte (économique, sociale et environnementale) du numérique,

la capacité du numérique à réduire l’empreinte (économique, sociale et environnementale) de l’humanité,

et la création de valeur durable / innovation responsable via le numérique pour réussir l’e-inclusion de tous.

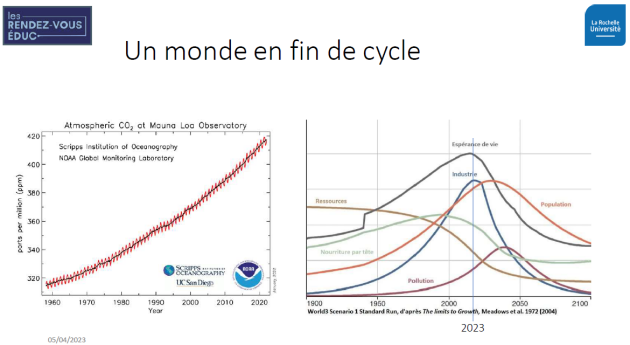

Dans un 1er temps, Vincent Courboulay a réalisé un état des lieux des conséquences environnementales et sociétales du développement du numérique. Notamment, il a montré que nous arrivons dans un monde en fin de cycle.

Les graphiques ci-dessous sont pour lui les plus représentatifs et les plus démonstratifs de ce phénomène.

Le graphique de gauche montre que les émissions de gaz à effet de serre au niveau mondial progressent depuis les 30 glorieuses et elles vont encore progresser pour un certain nombre d’années.

Le graphique de droite est connu depuis 51 ans. Il est issu d’une modélisation informatique, parue dans le [*]rapport Meadows[*], et montre qu’il n’y pas de croissance infinie dans un monde aux ressources limitées. Si cette limite est ignorée, un point de non-retour sera atteint et conduira à une chute combinée de la population, des ressources, de la production alimentaire et industrielle. Depuis la sortie du rapport Meadows en 1972, les chercheurs et chercheuses ont retravaillé ce modèle tout au long des années : à chaque fois, les conclusions correspondent, à quelques détails près, au monde d’aujourd’hui, où la surconsommation des ressources et la surpopulation de la planète menacent notre survie sur la Terre.

Ce modèle indique clairement que nous vivons, depuis quelques années déjà, un moment particulièrement instable avant de retrouver une certaine stabilité dans une quinzaine ou une vingtaine d’années. C’est à cela que l’on va devoir préparer les jeunes, comme les moins jeunes.

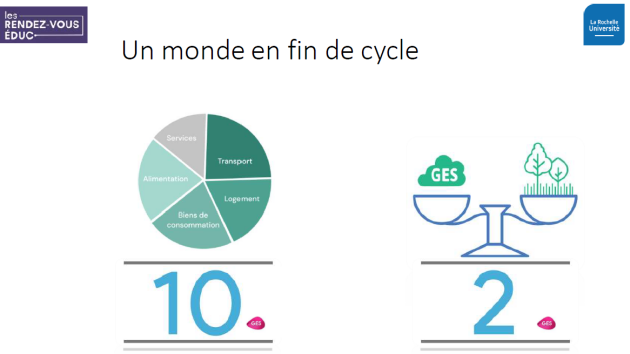

Au niveau individuel, nous sommes aujourd’hui à 10 tonnes d’émission de gaz à effet de serre par an et par français alors que les capacités de captation des émissions de gaz à effet de serre planétaire sont de l’ordre de 2 tonnes par personne. Cela veut dire que tant que l’on agira comme on le fait, on continuera à émettre en moyenne 8 tonnes de gaz à effet de serre qui partiront directement dans l’atmosphère et contribueront au réchauffement climatique.

En même temps que l’ancien monde est en train de disparaître, un nouveau monde apparait, celui du numérique.

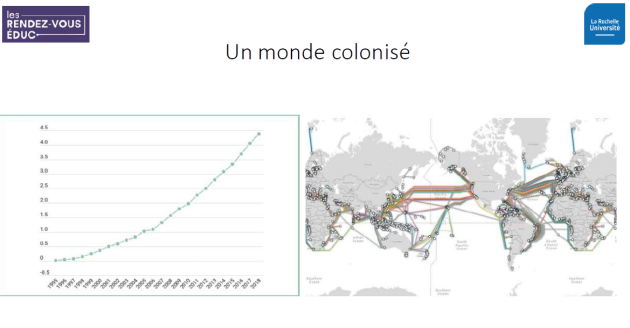

On estime que 1994 est une année charnière concernant la « colonisation » de ce monde numérique et nous sommes aujourd’hui plus de 5 milliards d’utilisateurs et d'utilisatrices. Cela veut également dire qu’il existe de nombreuses voies de communication. Pour l’immense majorité d’entre elles, ce sont des câbles de fibres optiques avec plus de 1,3 millions de kilomètres de câble, qui parcourent l’intégralité de la planète. On remarque une dorsale Europe, États-Unis, Chine, au détriment de tout le reste de la population, ce qui pose aussi des questions de l’ordre du « Néocolonialisme numérique ».

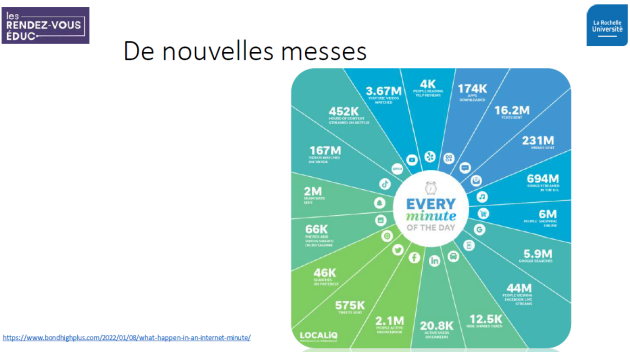

Qu’est-ce qui fait ciment dans cette nouvelle société ? Ce sont ces nouveaux dieux que tout le monde connaît et qui décident ce qui est bien ou mal.

Et si on a de nouveaux dieux, nous avons de nouvelles messes. Le graphique ci-dessous montre ce qu’il se passe sur internet en une minute : près de 6 millions de recherches sur Google, 500 heures de vidéos Youtube téléversées chaque minute, 575 000 tweets sont envoyés, 2 millions de snaps envoyés sur Snapchat, etc.

On pourrait penser qu’une stabilité arrivera. Mais dans le numérique, la stabilité n’existe pas car à chaque fois qu’on a l’impression de faire une pause, on repart sur de nouvelles technologies. Par exemple le fameux Chat GPT que tout le monde aujourd’hui connaît ou encore la 5G, sachant que la 6G arrive en 2028 !

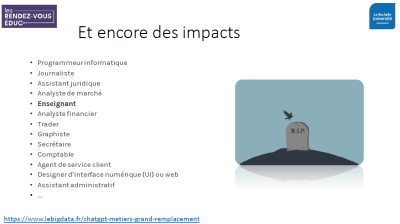

Enfin les images ci-dessous sont connues : à gauche, la photo d’un homme qui n’existe pas a fait la couverture d’une revue de photographie. Au centre, le pape en doudoune et à droite, des livres générés automatiquement par des intelligences artificielles. Tout cela étant généré quasiment sans aucun besoin d’intervention de professionnels.

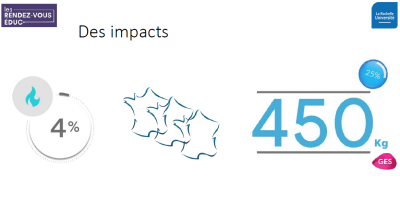

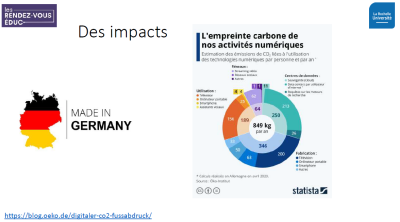

Cela a des impacts environnementaux et sociaux :

pour la fabrication d’un ordinateur de 2 kg, c’est une tonne de matières premières et des milliers de litres d’eau qui seront nécessaires.

4 % des émissions de gaz à effet de serre en France

une empreinte carbone d’à peu près 450 kg d’émissions de gaz à effet de serre par an et par français en France mais 850 kg en Allemagne

400 000 enfants travaillent dans des mines de cobalt, de République démocratique du Congo et des centaines de milliers d’autres personnes travaillent dans des conditions honteuses pour extraire la centaine de matériaux.

des métiers en danger ou appelés à évoluer

Alors comment concilier urgences climatiques et sociales avec la transition numérique engagée pour aller vers un numérique responsable ?

Il s’agit d’un numérique qui permettrait :

d’améliorer les impacts environnementaux, sociaux et économiques du numérique, ce qu’on appelle le « Green IT », avec les 3 piliers du développement durable : People, Planet, Prosperity (les 3 P), que l’on applique au numérique. À cela, on peut rajouter un quatrième P pour Protection. Cela inclut la protection de la vie privée, protection des données, protection des services, protection des sociétés, protection des organisations.

Image issue de la présentation de Vincent Courboulay (INR) - Peuple, Planète, Prospérité et Protection Mais aussi, parce que le numérique n’est pas que problème et qu’il fait aussi partie de la solution, essayer d’améliorer l’empreinte économique, sociale et environnementale par d’autres processus grâce au numérique. On appelle cela le « IT for Green ».

C’est cette espèce de résonance Green for IT et IT for Green qui définit ce que l’on appelle le numérique responsable.

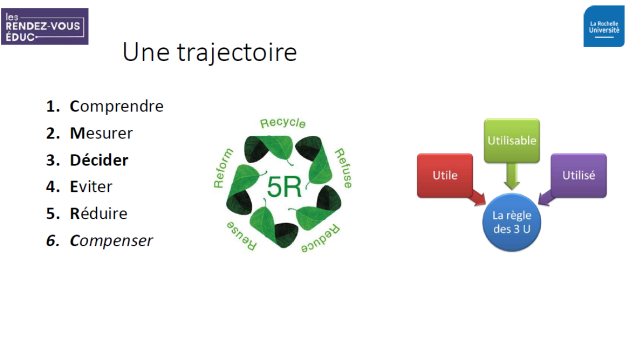

Vincent Courboulay a poursuivi en proposant une trajectoire à suivre :

Comprendre

Mesurer

Décider

Agir

La montée en compétence et la formation ont été évoquées et ce sont effectivement des enjeux très importants parce que ne nous pouvons pas correctement décider et agir si on ne comprend pas véritablement les problèmes. C’est pour cela que la trajectoire naturelle est d’abord un constat. Ensuite, on mesure : il faut des Open Data, des données publiques, promouvoir les méthodologies adaptées. L’Ademe, l’ARCOM, l’ARCEP, toutes ces autorités de régulation doivent mettre en place des données et des méthodes. Ensuite, il faut avoir du courage et décider. Aujourd’hui, c’est ce qui nous manque le plus, le courage pour décider : nous sommes capables de faire un constat, de poser des mesures. La question c’est : que faire maintenant ? Il faut peut-être inventer un numérique résilient, un numérique durable, un numérique responsable.

Patrick Sauret, Chef de projet informatique au sein d’Universcience, est intervenu pour expliquer qu’Universcience s’est engagé depuis un an dans la démarche label numérique responsable intégré à son projet d’établissement qui est en 3 piliers : l’innovation, la durabilité et l’esprit critique. Ces 3 piliers semblent ainsi correspondre à un plan de dissertation, avec la thèse, l’antithèse et la synthèse ! Un travail de fond est actuellement mis en place par Universcience avec l’application d’une méthodologie adaptée. Il s’agit d’analyser les différents objets numériques dont chacun dispose et que l’on manipule au quotidien, comprendre son impact et décider de la méthodologie à adopter.

Pour les organisations, comme pour les établissements scolaires, l’intérêt de la labellisation va être de faire connaître, développer et valoriser les actions.

Perrine Douhéret, chargée de projet DRANE[*] site de Lyon et enseignante de SVT a poursuivi en présentant une expérimentation qu’elle a élaborée et expérimentée avec des établissements scolaires de l’académie de Lyon. Cette labellisation comporte 5 axes :

Ce label est au croisement du label E3D et de celui de l’INR. Il est valable 3 ans et renouvelable comme pour le label E3D. On retrouve 5 axes qui correspondent à ceux du label de l’INR : la gouvernance, les usages, la formation, la communication et l’équipement, sur 3 niveaux, ce qui correspond au label E3D (engagement dans la démarche approfondissement et maîtrise). Il s’agit d’une expérimentation qui évolue en fonction des retours des établissements testeurs.

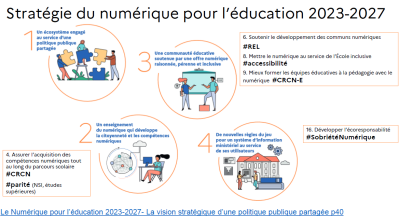

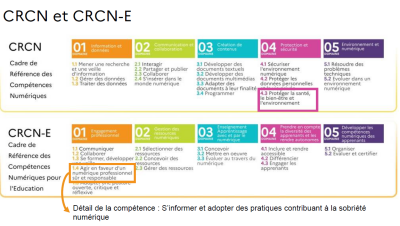

Le label permet d’avoir une vision systémique du numérique, en accord avec la stratégie pour l’éducation 2023-2027 ainsi qu’avec le cadre de référence des compétences numériques[*] (CRCN).

Complément : Supports de présentation

Complément : Ressources

Ouvrage « Vers un numérique responsable », janvier 2021, Actes Sud

6 épisodes du podcast « Le numérique responsable et l’INR avec Vincent Courboulay », septembre 2020

« Carbonalyser » : l’extension de navigateur qui révèle combien surfer sur le web coûte au climat (The shift project)

Malle pédagogique « Conscience Numérique Durable » conçue par la Ligue de l’enseignement 42

MOOC Numérique Responsable de l’INR

MOOC Impacts environnementaux du numérique de l’INRIA

Ludovic Fournier, médiateur scientifique de l’unité chimie et Vincent Pasquero, médiateur scientifique de l’unité Sciences de la Terre, Palais de la découverte, Universcience ont également aborder l'impact environnemental dans leurs interventions.

Voici les ressources utilisées dans leur présentation :

L’étude Ademe-Arcep évaluant l’impact environnemental du numérique, avec état des lieux + analyse prospective

La plateforme EcoInfo, unité CNRS qui regroupe chercheurs et chercheuses ayant pour finalités de mettre en lumière les impacts socio-environnementaux du numérique. Très riche également, plus diversifié aussi.

Et le rapport un peu plus ancien du Shift Project, parfois moins fin que l’étude Ademe-Arcep, avec des données contradictoires par rapport a ce dernier, certaines ont été ponctuellement contestées d’ailleurs, mais il a l’avantage d’être plus clair sur les pistes pour limiter l’impact.

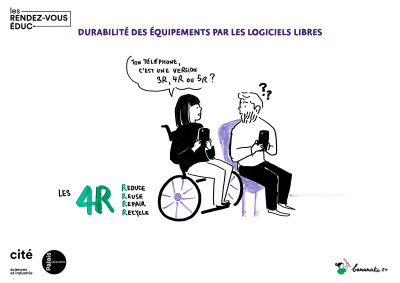

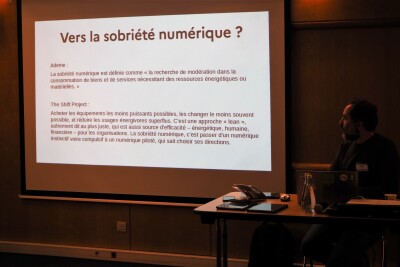

Durabilité des équipements par les logiciels libres, un enjeu fort au service de la sobriété numérique⚓

Par Julien Bonhomme, médiateur de ressources et services du numérique éducatif, Atelier Canopé 57, Réseau Canopé.

Les différents plans numériques dotent les établissements et les élèves en équipements numériques toujours plus nombreux or l’impact écologique de tous ces appareils est également de plus en plus important. Les rapports de l’ADEME montrent que 80 % de l’empreinte carbone d’un appareil mobile est liée à sa fabrication. Dans cet atelier, Julien Bonhomme, médiateur de ressources et services du numérique éducatif à Réseau Canopé a abordé avec les participant·e·s la question de l’obsolescence logicielle et matérielle puis a donné quelques pistes pour les réduire et prolonger la durée de vie des équipements. Une démonstration d’une installation d’un système libre sur une tablette tactile a été réalisé.

Complément : Support de présentation

Complément : Ressources

Etude ADEME-Arcep : évaluation de l’empreinte environnementale du numérique en France en 2020, 2030 et 2050

Upcycling Android : Actualisez votre téléphone et continuez de l'utiliser avec des Logiciels Libres !

« Un autre smartphone est-il possible ? L’open source pour collaborer pour le bien commun »

Exemple de systèmes alternatifs :

/e/OS - https://e.foundation/fr

LineageOS - https://lineageos.org

Fairphone - https://www.fairphone.com/fr

Discriminations, citoyenneté et numérique⚓

Justice sociale et environnementale : quelle place pour le numérique ?⚓

Par Maïtané Lenoir, designer indépendante et membre de l’association Framasoft[*]

Ces dernières années, le numérique est présenté systématiquement comme étant une solution… à tout ! Téléchargez une application pour éviter la crise sanitaire, lancez une start-up pour faire fortune, connectez-vous sur le site des impôts pour faire votre déclaration (et être un·e bon·ne citoyen·ne)… Plus simple, plus fluide, plus connecté·e·s, pour aller plus vite… mais vers quelle société ? Petite analyse critique de l’idéologie dominante et de ses impacts sur nos sociétés.

Maïtané a abordé le sujet sous trois grandes thématiques :

L'impact sur l'environnement

L'impact vis-à-vis du service public

L'impact vis-à-vis du privé et sur notre conception du monde

1 - L'impact sur l'environnement

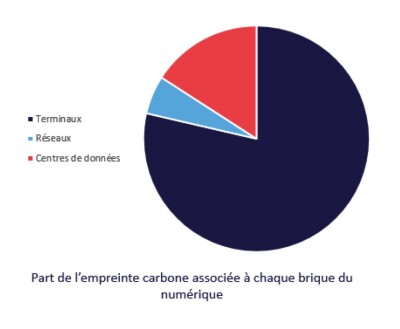

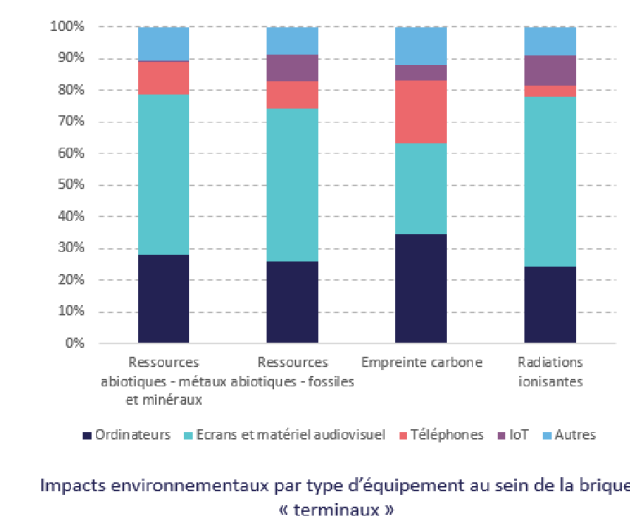

La moyenne de conservation d'un téléphone portable est de 2 ans et demi à 3 ans. Or, la fabrication est la phase principale d'impact environnemental d'un smartphone (78 %). Les mails n'ont qu'un faible impact sur l'environnement. L'empreinte environnementale est principalement liée aux terminaux : smartphones, tablettes, ordinateurs, consoles de jeux, télévisions. Les data centers représentent moins d'¼ de cette empreinte.

C'est la télévision qui a le plus fort impact sur l'environnement.

Lorsque l'on replace cela dans une contexte plus global, si l'empreinte carbone d'un français est en moyenne de 10 tonnes (il faudrait que l'on réduise pour arriver à 2 tonnes), la part du numérique est de 217 kg.

Ceci ne veut pas dire que le numérique n'est pas en enjeu car sa croissance est exponentielle mais que nos actions doivent être considérées dans un contexte plus général et que les enjeux doivent être fixés à un niveau collectif.

2. L'impact vis-à-vis du service public

Il a été fixé au début du mandat d'Emmanuel Macron un objectif de dématérialisation des services publics à 100 % en 2022.

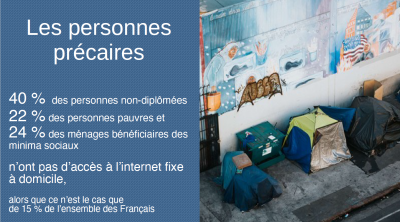

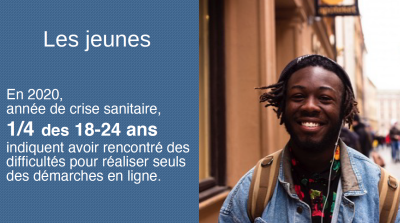

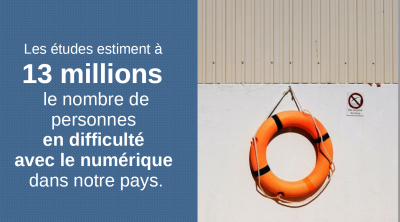

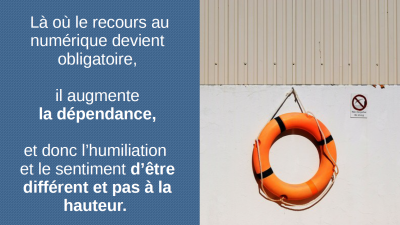

Si cet objectif est aujourd'hui pratiquement atteint, certains publics sont exclus par cette dématérialisation : les personnes âgées, les personnes en situation de handicap, les personnes précaires, les allophones, les personnes étrangères, les jeunes, les personnes en zones blanches ou encore possédant un matériel vieillissant. Les études estiment que 13 millions de personnes sont en difficulté avec le numérique dans notre pays : « là où le recours au numérique devient obligatoire, il augmente la dépendance, et donc l’humiliation et le sentiment d’être différent et pas à la hauteur ». (Rapport sur la dématérialisation des services publics, défenseurdesdroits.fr).

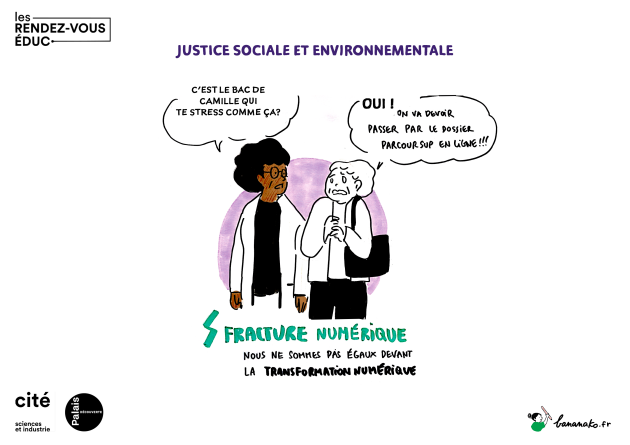

Dans le milieu scolaire, cela crée une fracture sociale : manque de matériel numérique, différences dans l'aisance d'utilisation des outils numériques des familles et des élèves. Nous nous en sommes particulièrement rendu compte pendant le confinement. D'autres exemples peuvent être cités aujourd'hui. Notamment l'usage obligatoire de la plateforme Parcoursup, déterminant pour le parcours scolaire des jeunes, engendre des difficultés et discriminations pour les familles les moins à l'aise avec les outils numériques.

On court vers le progrès technique en pensant que cela va amener à un progrès social. Or on constate actuellement exactement l'inverse : le tout numérique et la réduction des services publics physiques entraînent une régression sociale. Il s'agit là d'enjeux et de choix qui se situent au niveau politique et collectif et non individuel.

Maïtané fait un lien entre la culture numérique et le capital social de Bourdieu, en référence à un article de Louis Derrac. Il est nécessaire d'éduquer tout le monde, les jeunes comme les adultes pour pouvoir avoir une transmission des savoirs suffisante et aller au-delà des différences de classes sociales.

3 - L'impact vis-à-vis du privé et sur notre conception du monde

On prône souvent l'éducation aux médias et à l'information (EMI) pour sensibiliser et éduquer les jeunes à toutes ces problématiques telles que celles de la question des données personnelles.

Si cette EMI est très importante, elle peut aussi être culpabilisante pour les jeunes du fait notamment qu'elle se situe au niveau individuel. Il est cependant possible de réinterroger le contexte et la responsabilité des plateformes capitalismes telles que les GAFAM (Google, Apple, Facebook, Amazon et Microsoft). Les plus touchées par cette culpabilisation vont être les femmes et les pauvres ou encore les personnes à la santé mentale fragile. Des règles collectives pourraient être plus protectrices vis-à-vis de ces personnes plutôt que de leur en faire porter la responsabilité.

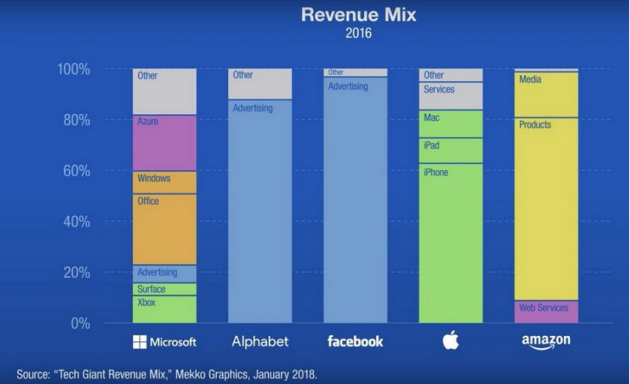

Le modèle économique de ces plateformes est la publicité. La quasi totalité des revenus de Google (Alphabet) et Facebook provient de la publicité, selon une étude de Mekko Graphics en janvier 2018.

Mais le plus intéressant pour ces entreprises est de capter les données personnelles pour prédire les comportements et influencer nos choix.

Comment font-ils cela ? Par des bulles de notifications (rouges !), la mise en place de mécanismes « addictifs », en suscitant des émotions « négatives ».

Quels types de données personnelles sont récupérées ? Certaines de ces données ne sont même pas connues par nous-mêmes ! Ce sont notamment des informations sur la personnalité et le comportement : degré d'ouverture, d'amabilité, neuroscepticisme, etc.

À titre d'exemple, Maïtané cite ce qu'il s'est passé en 2010 lors de la campagne électorale présidentielle de Trinité & Tobago. Dans cette affaire, Cambridge Analytica[*] est intervenu en faveur du parti majoritairement indien (UNC) opposé au « parti pour les Noirs ». Ceci a été possible grâce à l'aspiration par Cambridge Analytica de millions de données personnelles des utilisateurs de plateformes comme Facebook leur permettant d'établir le profil de ces utilisateurs, en recoupant leurs goûts, leurs habitudes, etc. Et in fine, de cibler les indécis lors des scrutins électoraux et de peser sur leur vote.

L'idée est de repenser le numérique qui n'est ni bon, ni mauvais, ni neutre. Les personnes qui mettent en place ces technologies ont un biais, reste à chacun d'entre nous, collectivement, de choisir si c'est vers ce biais que l'on veut aller ou pas. On peut utiliser le numérique tout en développant un regard critique pour aller vers un numérique émancipateur permettant une justice sociale et écologique. Ce numérique existe déjà ! Un numérique qui prend soin, qui partage le pouvoir…

L'important est ainsi de savoir vers quel numérique on veut aller.

Visionner la table ronde en vidéo :

Complément : Support de présentation

Complément : Ressources

Rapport sur la dématérialisation des services publics, defenseurdesdroits.fr

« Parcoursup : selon l’origine sociale des lycéens, une orientation à armes inégales », article Le Monde.fr, publié le 18 janvier 2023

« Parcoursup, un nouveau marché pour les acteurs privés du conseil en orientation », article le Monde.fr, publié le 09 mars 2018

« Parcoursup, l’ère de l’anxiété généralisée », podcat le Monde.fr

« Parcoursup : beaucoup reste à faire pour humaniser le système », article le Monde.fr, publié le 16 janvier 2023

« Du concept de « fracture(s) numérique(s) » à celui de capital numérique ? », article de Louis Derrac, publié le 19 novembre 2020

« Five points for anger, one for a ‘like’: How Facebook’s formula fostered rage and misinformation », article The Washington Post

« Twitter admet qu’il amplifie plus la droite française que la gauche », article Numérama

« Twitter assume n’avoir quasiment pas de modérateurs humains », article Numérama

« Twitter emploie moins de 2.000 modérateurs dans le monde entier », article 20 minutes, publié le 10 décembre 2021

Discriminations liées aux usages du numérique⚓

Thierry Thibault, médiateur au Carrefour numérique² de la Cité des sciences et de l’industrie, a proposé une conférence ouverte mêlant expériences vécues et racontées autour des usages ou des non-usages des outils numériques. L'objectif était d'amener le public à prendre conscience des problèmes que peuvent rencontrer n’importe qui face à la surutilisation des outils informatiques dans la vie personnelle, professionnelle et citoyenne.

Qui sont donc les personnes discriminées par le numérique ? Puis comment ces discriminations agissent et se mettent en place ? Avec quels outils se créent des discriminations ?

Cet atelier a été présenté sous forme de conférence gesticulée.

« C’est la rencontre entre des savoirs chauds (savoirs de vie et savoirs populaires utiles à l’action collective) et des savoirs froids ( savoirs théoriques et politiques), cela ne donne pas des savoirs tièdes… ».

D'après Franck Lepage

« La conférence gesticulée est une prise de parole publique sous la forme d’un spectacle politique militant. »

« Construite par une personne ou un groupe à partir de ses expériences, c’est un acte d’éducation populaire fondé sur l’envie de partager ce qu’on a compris, tel qu’on l’a compris, là où on l’a compris. »

D'après Franck Lepage

https://conferences-gesticulees.net/une-conference-gesticulee

Citoyenneté et jeu vidéo⚓

Loisir aujourd’hui incontournable, le jeu vidéo est un média numérique en constante évolution. Quelle vision du monde, message de sensibilisation sont diffusés ? Quelles problématiques sociétales soulèvent-ils ? Quelle place des femmes dans l’industrie des jeux vidéo ? Quelle inclusion possible ? Quels usages pédagogiques possibles ?

L’idée de cet atelier/présentation animé par Patrice Baudhuin, coordinateur de l’offre de médiation jeu vidéo sur l’e-LAB (espace jeu vidéo) à la Cité des sciences et de l’industrie, était d’échanger sur le jeu vidéo en tant que médium, de présenter succinctement son importance dans la diffusion des technologies du numérique auprès du grand public ainsi que la spécificité qui le distingue des autres média (par exemple, l’interactivité). Il s'agissait aussi de montrer son intérêt comme support pédagogique et moyen de diffuser un message, un contenu qui puisse aller au-delà du loisir.

Première partie : Un peu d’histoire, le jeu vidéo comme ambassadeur des technologies du numérique auprès du grand public.

Dans les années 50, l’informatique familiale n’existait tout simplement pas ; les quelques rares ordinateurs existants étaient utilisés pour la recherche, principalement dans les laboratoires ou les universités américaines. C’est là que les premiers jeux vidéo jamais créés sont apparus ; ils avaient pour but d’expérimenter avec un ordinateur, l’informatique étant totalement balbutiante à cette époque. Certains des premiers jeux de l’histoire avaient vocation de tester de nouvelles interfaces de communication avec la machine. C’est notamment le cas d’OXO (photo à droite, 1952) ou de Tennis for two (1958), deux jeux ayant grandement contribué à simplifier l’usage d’un ordinateur grâce à l’utilisation d’interfaces simplifiées (écrans, contrôleurs pour jouer).

Ainsi, le jeu vidéo va permettre non seulement d’accompagner la simplification de l’usage de l’informatique, mais va aussi contribuer à sa pénétration dans les foyers avec l’arrivée des premiers ordinateurs 8/16 bits qui serviront principalement de machines de jeu à cette époque.

La simplification d’usage apporté par le jeu vidéo va souvent au-delà du simple domaine de l’informatique de loisirs. Ainsi, la croix directionnelle inventée en 1983 par Nintendo est aujourd’hui encore présente sur toute les télécommandes du monde. Les écrans tactiles, aujourd’hui massivement utilisés sur smartphones et tablettes tactiles, ont eu pour premier ambassadeur la console portable Nintendo DS dès sa sortie en 2004 au Japon et 2005 en Europe (l’iPhone n’est arrivé qu’en 2007). Le jeu vidéo est l’une des principales utilisations des masques de réalité virtuelle, et des innovations liées à l’utilisation du motion gaming (jeu vidéo utilisant les mouvements du corps) tel que la Wiimote ou le Kinect sont utilisées aujourd’hui dans des domaines comme la santé, la muséologie, etc.

Deuxième partie : le jeu vidéo comme médium

Le jeu vidéo est un médium : Le terme médium désigne tout moyen de distribution, de diffusion ou de communication, d'œuvres, de documents, ou de messages écrits, visuels, sonores ou audiovisuels (comme la radio, la télévision, le cinéma, Internet, la presse, les télécommunications, etc.). Il permettrait donc de faire passer des messages, des contenus. Sous formes de scénarios et donc d’histoires, d’images, de sons, le jeu vidéo envoie de nombreuses informations aux joueurs et joueuses. Si la plupart de ces contenus relèvent uniquement de la fiction pour construire un contexte de jeu (scénario), certains jeux ambitionnent d’aller plus loin : susciter une réflexion, faire passer un message sur la société, sensibiliser à une cause. Ces « serious games » ou jeux sérieux ont vocation à amener une réflexion sur un sujet, de transmettre une notion pédagogique, de sensibiliser à une cause.

Jouer avec la politique : apprendre la gestion du monde

Il y a aujourd'hui plein de jeux permettant de faire de la politique en virtuel, grâce à un gameplay adapté. Par exemple, les jeux de stratégie permettent d'aborder quelques notions en politique car ils demandent au joueur et joueuse de prendre des décisions, faire de la géopolitique virtuelle, utiliser la diplomatie, etc. Le propos politique de ces jeux est forcément biaisé : le joueur ou la joueuse est placé en situation démiurgique la plupart du temps : ses décisions sont incontestées et incontestables, il n’y a pas de contre-pouvoir, le joueur ou la joueuse y est tout puissant. Mais ils peuvent avoir une véritable portée pédagogique : ils peuvent donner un aperçu des différents facteurs intervenant dans la gestion d'une ville ou d'un pays, comprendre les enjeux et la stratégie mise en œuvre lors d'une élection ; ils peuvent aussi permettre de mieux s'approprier un contexte géopolitique.

Certains jeux utilisent la politique comme élément de gameplay : ils peuvent être utilisés pour sensibiliser à une situation, un conflit. Les USA en ont produit beaucoup, comme par exemple :

Sorti pour chaque élection présidentielle depuis 2004 (5 épisode en tout), ce jeu permet de revivre totalement une campagne présidentielle américaine, avec tout ce qu’elle implique : préparer des meetings, nouer des alliances avec des élus, trouver des financements, etc.

Le jeu vidéo un médium interactif

Si le jeu vidéo est un médium qui permet de diffuser des idées, au même titre que la télévision, la presse ou la radio, le fait qu'il soit interactif le rend potentiellement plus impactant car le joueur ou la joueuse est y actif. D’où le développement de ce que l’on appelle des « Serious games » ou « jeux sérieux », ayant un but pédagogique. Ces jeux spécifiques peuvent, par exemple, informer et sensibiliser à des grandes causes, comme l’écologie ou le handicap par exemple :

Les jeux vidéo peuvent-il sensibiliser à la cause écologique ? - Article Le Monde, publié le 01 avril 2019

Quand le jeu vidéo s'approprie l'enjeu écologique - Article Les Échos, publié le 12 août 2020

Handicap : 4 jeux vidéo mobiles qui brisent les préjugés ! - Article Talenteo

Les institutions étatiques commencent à s'intéresser au jeu vidéo depuis quelques années ; il est l’objet d’expositions, il fait son entrée dans des institutions culturelles (comme la Cité des sciences et de l’industrie) et les créateurs de jeux vidéo sont maintenant reconnus :

David Cage bientôt Chevalier de la Légion d'Honneur - Article Les Numériques

Le jeu vidéo acquiert ses lettres de noblesse - Article Le Monde

En 2019, le Ministère de la culture produit son premier jeu vidéo : il s’agit de Romanica, qui a pour sujet la francophonie dans de la cadre de la saison culturelle France-Roumanie en 2019 :

http://www.club-innovation-culture.fr/ministere-culture-jeu-video-romanica

Le jeu vidéo, un outil de communication politique

Si le jeu vidéo peut diffuser des idées, et que le monde politique et institutionnel commence à en reconnaître l'impact et la portée, la question de son utilisation à des fins communicationnelles se pose. Selon les Chiffres du SELL novembre 2022 : 7 français sur 10 jouent au moins occasionnellement aux jeux vidéo. Âge moyen du joueur ou joueuse en France : 39 ans.

Source : L'essentiel du jeu vidéo - Novembre 2023

Faire passer un message par les jeux vidéo, c'est donc toucher potentiellement beaucoup de monde. De plus, ce médium touche plus certaines catégories que médias traditionnels, notamment les jeunes. Ainsi, on a vu ces dernières années l’apparition de « jeux vidéo de campagne » : le phénomène n'est pas nouveau, mais il a pris une ampleur grandissante lors de la dernière élection présidentielle.

https://fr.wikipedia.org/wiki/Fiscal_Kombat

Ce jeu a été créé par des bénévoles proches du parti de Jean-Luc Mélenchon dont il prend totalement le parti. Il contient un message sous-jacent sur l'évasion fiscale, le partage des richesses, etc. Si la portée du message politique de ce jeu potache est sujette à débat, le coup de comm. est indéniable et le jeu va marquer.

Jeu accompagnant la campagne d’E. Macron pour la présidentielle de 2017 ; créé par des sympathisants du candidat.

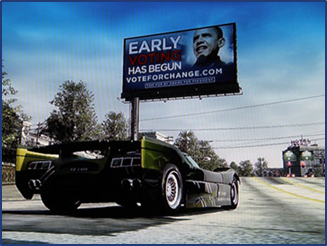

En 2008, l’équipe de campagne de Barack Obama va diffuser des visuels du candidat dans des jeux vidéo se jouant en ligne ; les panneaux publicitaires virtuels que l’on voit dans les jeux Burnout Paradise et NBA Live 2008 pouvant être mis à jour via internet, des visuels de campagne vont y être diffusés pour toucher les joueurs et joueuses. Pour la première fois, une campagne présidentielle s’invite dans les jeux vidéo.

Le soft power : diffuser une certaine vision du monde.

Le jeu de tir à la première personne fait aujourd’hui partie des jeux les plus prisés. Beaucoup de ces jeux prennent place soit dans des conflits modernes, soit revisitent l'histoire en plongeant le joueur ou la joueuse dans certains des grands conflits historiques, notamment la 2nde guerre mondiale. Ces jeux de guerre reposent sur une conception du monde qui date de la guerre froide ; de par leur mise en scène, spectaculaire, ces jeux se posent souvent comme des blockbusters vidéoludiques équivalent aux grands succès hollywoodiens mettant en scène des héros du « monde libre ». Mais le message délivré est parfois ambigu et très « pro-occident », posant des questions sur la façon dont certains événements historiques peuvent être présentés, à la limite de la réécriture historique.

Ces jeux proposant une vision unilatérale et héroïque de la guerre peuvent d'ailleurs être utilisés pour recruter des gens :

America's army (2002)

Co-développé avec l'armée américaine, ce jeu de tir militaire a pour but avoué l’augmentation des recrutements de l'armée. Le jeu a amené les meilleurs chiffres de recrutement depuis la fameuse campagne « I want you for US army » de 1941 ; la 5e version est sortie en 2018.

Les événements décrits dans certains de ces jeux de guerre posent la question d'une éventuelle interprétation/réécriture de l'histoire, souvent unilatérale:

Dans un chapitre de son histoire, ce jeu utilise comme toile de fond une réinterprétation d’un épisode sanglant de la 1ère guerre du Golfe : la Highway of death. Qualifié de crime de guerre commis par les USA, cet événement est attribué dans le jeu aux Russes. Résultat : polémique internationale, la Russie boycotte le jeu.

Six days in Fallujah, 2023

Six Days In Fallujah Publisher - Article IGN

Ce jeu très récent a créé un polémique avant sa sortie : il propose au joueur ou à la joueuse de (re)vivre les événements de la bataille de Fallujah pendant la seconde guerre du Golfe. Le fait de (re)vivre cet événement historique particulièrement atroce suscite énormément de réactions, et pose la question de ce que l’on peut adapter en jeu et surtout comment. Le jeu est si controversé qu’on ne sait toujours pas s’il sortira un jour.

Ces incursions/réécritures de la réalité selon un point de vue biaisé sont finalement relativement courantes : on voit cela dans les films, les séries, les romans etc. Cela pose bien sûr la question de l’influence exercée via les produits culturels, ce que l’on appelle couramment le « soft power ». Ces deux exemples de jeux remaniant l’histoire sont extrêmes, et ne reflètent absolument pas l’ensemble des jeux vidéo produits. Mais de la même manière qu’il est nécessaire d’analyser un livre ou un film, ce afin de mieux appréhender son contenu et faire la part des choses, le jeu vidéo nécessite aussi dans certains cas d’être décrypté pour être mieux appréhendé, notamment par les plus jeunes.

Conclusion

Le jeu vidéo a depuis un certain dépassé les limites du simple loisir : on le qualifie aujourd'hui d'art à part entière, on étudie son impact sociétal, son potentiel éducatif, le contenu qu’il délivre ; il est donc finalement assez peu étonnant qu'il puisse être un moyen de diffuser des idées, de sensibiliser à des causes . En somme, le jeu vidéo est un médium : comme la télévision, la radio ou le cinéma, il peut être tout à la fois un objet de loisir comme un objet permettant de diffuser/accompagner des idées, des messages. C'est en cela qu'il nécessite parfois d'être analysé et expliqué, et qu'il faut parfois accueillir certains propos (comme pour les jeux de guerre) avec un certain recul.

Quel futur ?⚓

Métavers : utopie ou dystopie ?

Quel futur pour internet ? Les innovateurs·trices et les investisseurs·seuses de l’internet travaillent actuellement sur une structure est censé être décentralisée avec d’innombrables plateformes interopérables, le Web 3.0 ou le Métaverse. De nombreux débats et critiques de ce Web 3.0 ont animé la société. Justine Gasc, médiatrice numérique, Carrefour numérique², Universcience a organisé un temps d’échange autour de la notion du métavers et des changements que cette nouvelle technologie va apporter dans nos vies, autour de 4 axes.

En premier, l’atelier a proposé de revenir sur la définition du métavers à travers un bref retour historique et une présentation des évolutions possibles ainsi que quelques notions techniques. Puis les nouveaux enjeux entrainés par cette technologie ont été abordés, autour de questions environnementales, mais surtout sur les impacts que le métavers et les nouvelles interfaces liées au métavers peuvent avoir sur la santé, au niveau physique mais aussi mental. Les questions de la protection des données, de justice autour du harcèlement par exemple, des différents types de modérations possibles, d’inclusion et de diversité ont été soulevées.

Pour finir, un focus a été fait sur l’utilisation de ces métavers dans le milieu de l’enseignement, à travers de la théorie et des cas pratiques, de ces nouveaux outils pour imaginer la classe de demain et le développement des technologies immersives dans l’éducation ? Mais dans quels buts ? Pour quels bénéfices ? Quels nouveaux défis ?

Vous retrouverez ci-dessous le support de présentation de cet atelier.

Complément : Support de présentation

Complément : Ressources

Le métavers est-il compatible avec le numérique responsable ?

Réalité virtuelle ou augmentée, l’autre bataille du métavers

Le métaverse : tout savoir sur l’univers fictif qui affole les GAFAM

Métavers et enseignement : gadget ou vraie innovation pédagogique ?

Réfléchir dès maintenant au potentiel du métavers en éducation

Le métavers et la réalité étendue : l’avenir de l’enseignement supérieur ?

4 exemples de stratégies pédagogiques d’utilisation du jeu en classe… et le métavers